تابع هزینه قسمت سوم

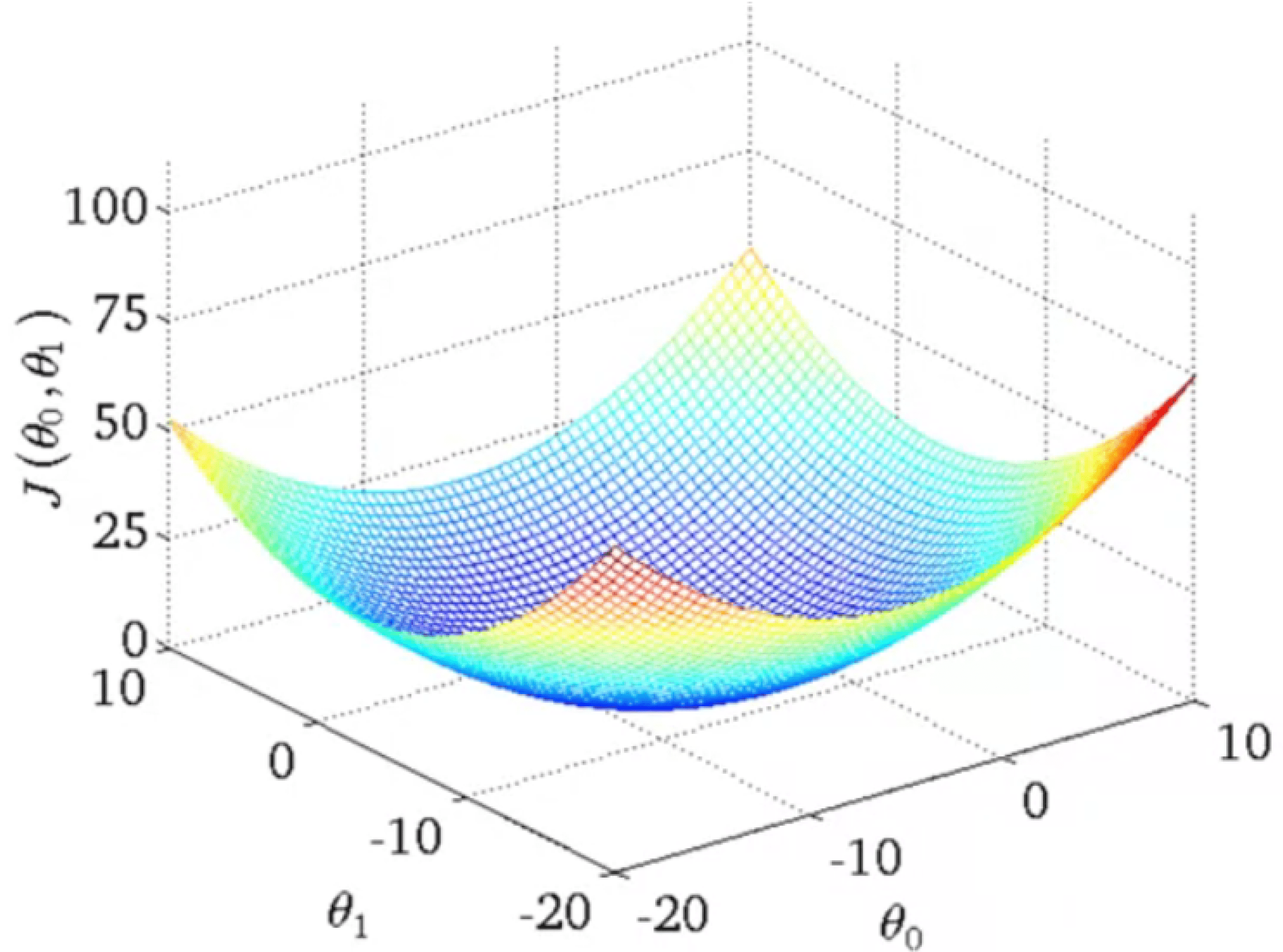

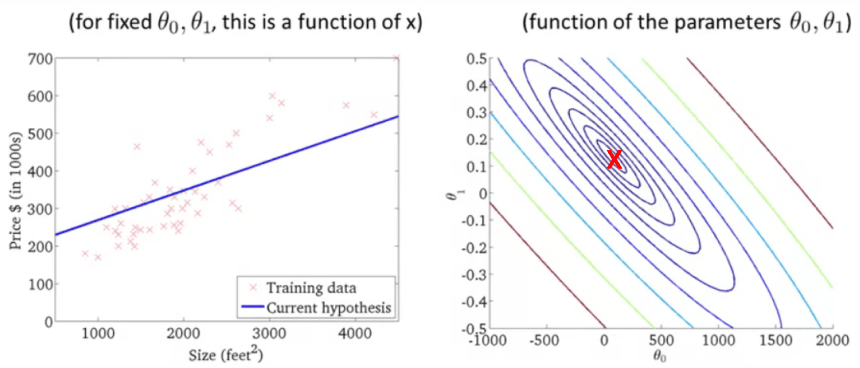

قسمت قبل دیدیم که با داشتن فقط یک پارامتر برای تابع فرضیه نمودار تابع هزینه یا همان $J$ به صورت سهمی بود. اگر دو پارامتر داشته باشیم باز هم به صورت سهمی است، اما سه بعدی و بسته به داده ما ممکن است به شکل زیر باشد:

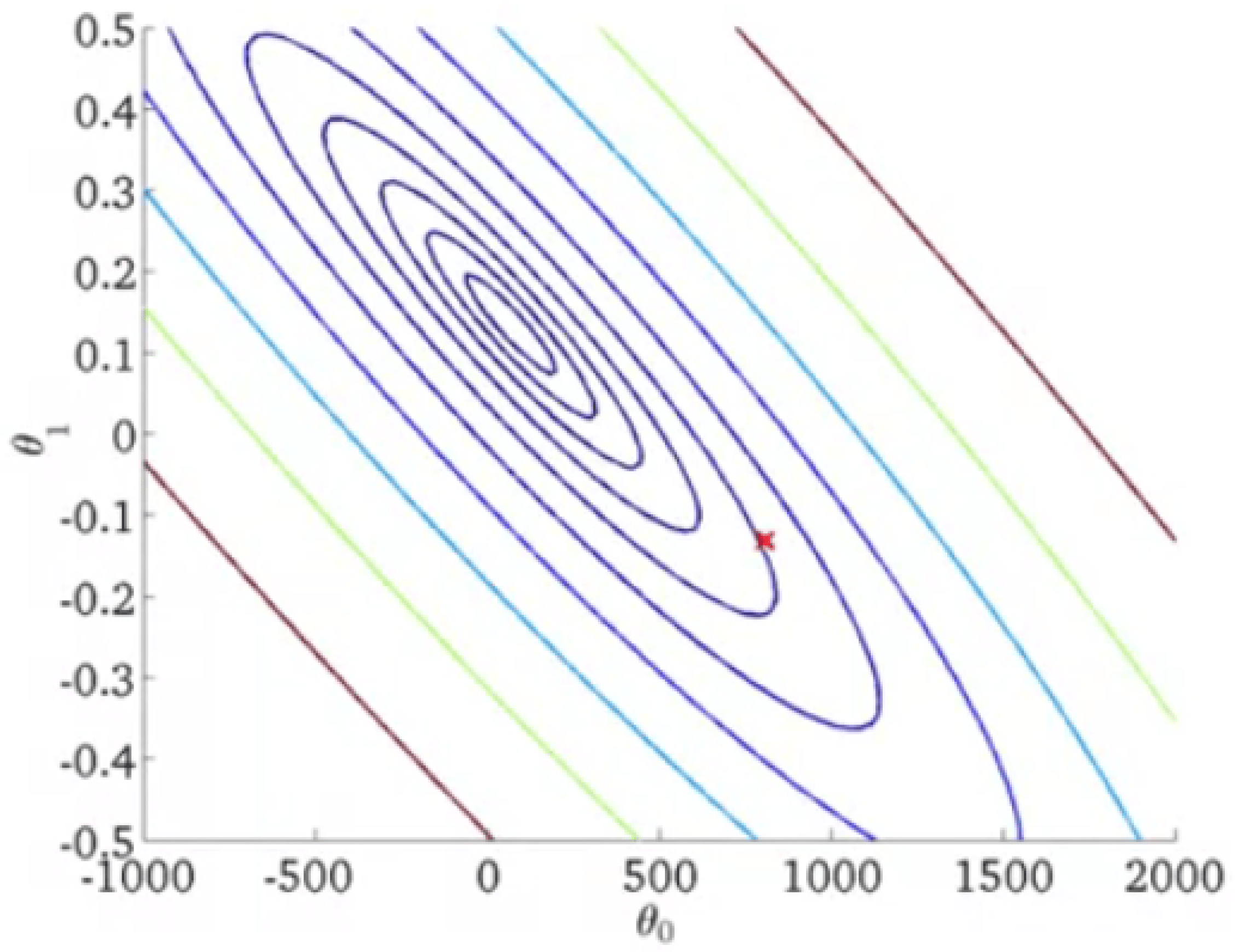

اما ما برای نمایش این تابع از شکل سه بعدی استفاده نمیکنیم، بلکه از نمودار های کانتور استفاده میکنیم!

در این نمودار ها هر یک از بیضی ها نشان دهنده مجموعه ای از نقاط است که مقادیر یکسانی در $J$ بر حسب $\theta_0$ و $\theta_1$ های مختلف دارند.

مثالی از یک نمودار کانتور:

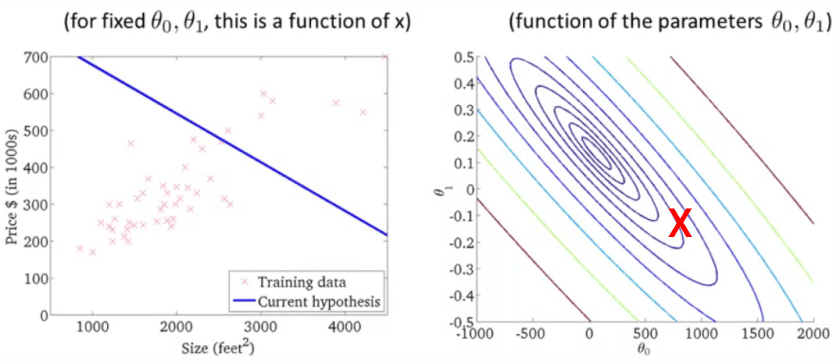

مثلا نقطه قرمز روی نمودار کانتور سمت راست برابر است با: $ \theta_1 = -0.15, \theta_0 = 800 $

اما همینطور که میبینیم خط حاصل از تابع فرضیه تناسب خوبی با داده های ما ندارد! به این خاطر که نقطه ما از مینیمم که کوچکترین بیضی است خیلی دور است!

در این نقطه جدید هم کاملا مینیمم نیست اما خیلی بهتر از قبلی است. باز هم خط حاصل از تابع فرضیه بر حسب مقادیر انتخابی برای دو پارامتر مسئله با داده های ما متناسب نیست …

در واقع ما به الگوریتمی نیاز داریم که برای ما مقادیر $\theta_0$ و $\theta_1$ را در حالتی که تابع $J$ مینیمم است بیابد.

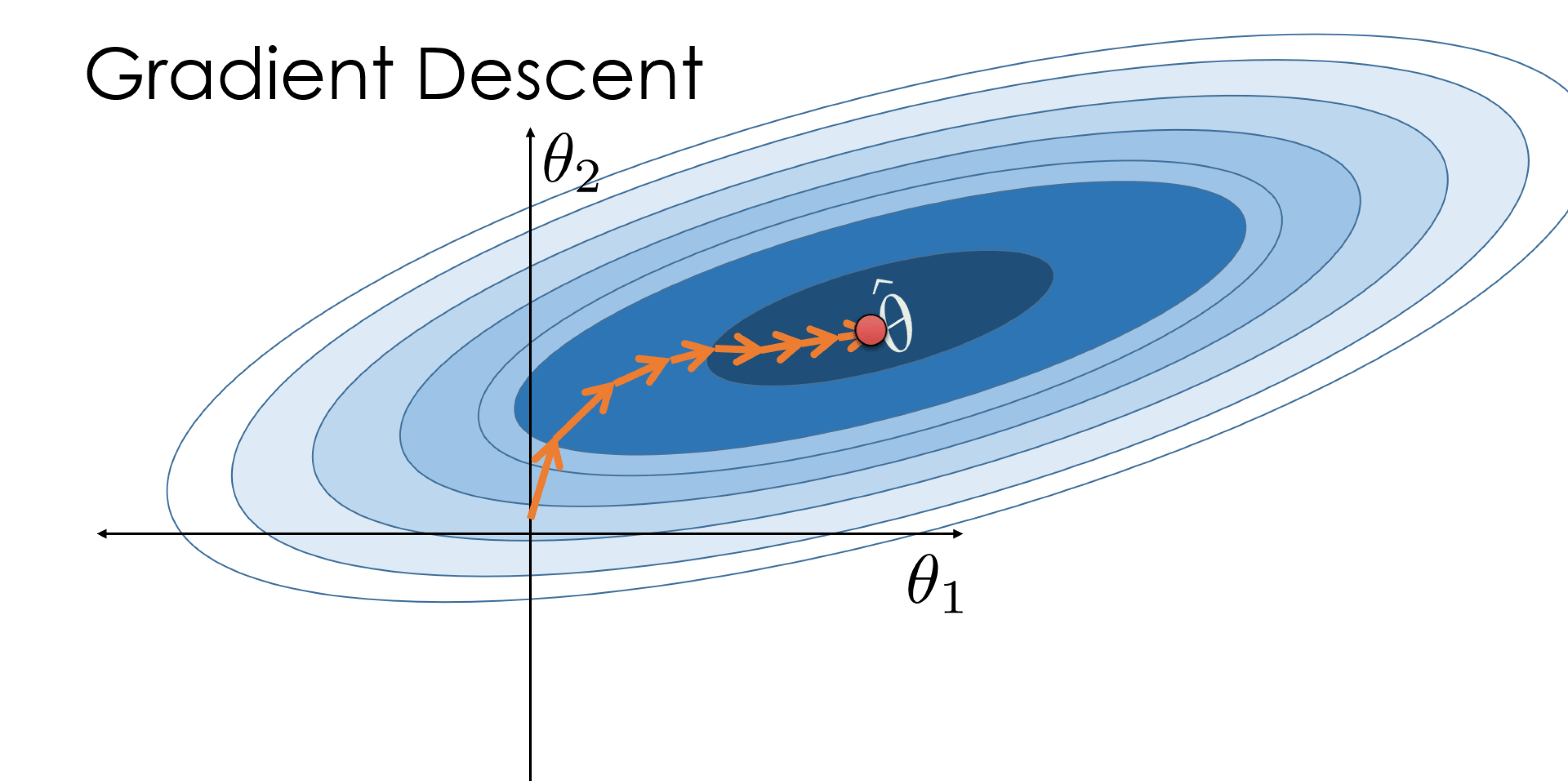

که پاسخ ما گرادیان کاهشی است !